Wieder haben wir eine SEOkomm genossen und es ist an der Zeit, einen kleinen Recap zu verfassen. In Kurzform: Es war erneut ein Event mit gesetzten Größen und jungen Newcomern auf der Bühne, mit spannenden Themen und vielen wichtigen Insights, die im Alltag umgesetzt werden wollen. Vor allem: Es war wie jedes Jahr ein Vergnügen und wichtiger Wissenslieferant.

Größte Auffälligkeit dieses Jahr?

Wie sich schon letztes Jahr deutlich abgezeichnet hat, wird SEO wieder technischer und muss /sollte/darf sich mit neuen Technologien auseinandersetzen. Sprachassistenten sind dank Alexa, Siri, Cortana und Co mittlerweile in der Mitte unserer Gesellschaft angekommen und AMPs, sowie PWAs und JS verändern die Art, wie Webseiten gebaut und indexiert werden. Analysen können durch „machine learning“ und „Big Data“ auf eine völlig neue Ebene gezogen werden.

DIE „neue“ Geheimwaffe?

Google Search Console – Fetch&Render: Bringt den Google Crawler direkt auf die Seite, auf der ihr ihn benötigt. Ihr seht, wie sich JavaScript-Seiten für den Bot darstellen und lasst neue Inhalte indexieren, alles per Knopfdruck

Mein persönliches Highlight?

Endlich im ScreamingFrog-Analysen–Vortrag gewesen zu sein, den ich gefühlt schon seit Jahren versucht habe auf verschiedenen Konferenzen zu hören und immer verpasst habe.

Was haben wir mitgenommen?

Wie jedes Jahr wurden die SEOkomm durch eine spannende und durchaus lehrreiche Keynote von Marcus Tandler eröffnet. Da ein (Bewegt-)Bild bekanntlich mehr sagt als tausend Worte, hier der Link, um sich die Keynote mit dem Topic Position Zero noch einmal anzusehen (für die Ungeduldigen: Ab 17:15 geht’s los).

Hatte er als Keynote-Speaker eigentlich gleichzeitig auch Position Zero der SEOkomm?

„Nutzt Daten statt zu raten.“ Mit dem Schlusssatz aus Sebastian Erlhofers Slot lässt sich der Vortrag in einem prägnanten Satz extrem gut zusammenfassen.

Die Zeiten, in denen wir uns rein auf das Bauchgefühl und Erfahrungswerte verlassen konnten, neigen sich dem Ende. Wir verfügen über eine Unmenge an Informationen und dank Machine Learning mittlerweile auch über die Technologie, diese in großem Stil auszuwerten. Datengetriebene Analyse sollte für jeden von uns zu einem Pflichtthema werden.

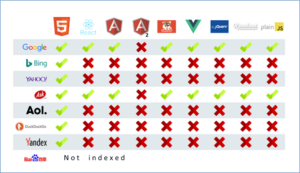

Ebenfalls für viele ein heikles Thema wurde uns von Artur Kosch näher gebracht: SEO für JavaScript-Seiten. Diese Seiten liefern technikbedingt für Bots (der Code liest) andere Inhalte aus als für User (Frontend). Entsprechend müssen hier Prerendering-Tools zum Einsatz kommen. Erschwerend kommt hinzu, dass viele Crawler nicht alle JS-Frameworks verstehen und somit JavaScript überhaupt nicht indexieren. Wer sich für dieses Thema interessiert, sollte unbedingt den Artikel von Bartosz Góralewicz (hier der Link) lesen, der sich intensiv damit befasst hat.

Content-Failures

Natürlich waren nicht nur für die Techniker unter uns etwas geboten. Auch Freunde des gepflegten Contents sind nicht zu kurz gekommen. Hier hervorzuheben war die Session von Thomas Mindnich, der in seinem Vortrag klar dargelegt hat, weshalb eigentlich ein Erfolg von SEO-Texten nicht mehr garantiert werden kann, wohl aber festgestellt werden kann, weshalb Inhalte versagen. Die Wichtigsten Punkte um eure Inhalte nicht zu Content-Failures werden zu lassen:

• Achtet auf eure Termgewichtung

• Positioniert eure Inhalte richtig

• Erfüllt den Userintent

• Trefft euer Thema

• Schreibt umfassende Inhalte und presst nicht alles in einen Text

Amazon SEO

Einen letzten Vortrag, der sich absolut gelohnt hat war definitiv der Amazon-SEO-Vortrag von Christian Kelm, der spannende Insights in seine tägliche Arbeit mit Amazon gegeben und noch einmal betont hat, wie wichtig eine saubere Planung von Zielgruppe, Keywords und Marktsituation ist. Ist natürlich auch im „klassischen“ SEO wichtig, aber für Amazon noch mehr.

In diesem Sinne, wir freuen uns schon jetzt wieder auf das kommende Jahr und werden bis dahin alles Neue verinnerlichen und umsetzen!

Viele Grüße von den SEO Daniels